ChatGPT versieht die von DALL-E 3 erzeugten Bilder mit digitalen Tags

In der heutigen Zeit, in der Betrüger generative KI für Betrügereien oder Verleumdungen einsetzen, entwickeln Technologieunternehmen Methoden, die den Nutzern helfen, Inhalte, insbesondere Bilder, zu überprüfen. Im Einklang mit der Anti-Desinformations-Strategie für das Jahr 2024 enthält OpenAI jetzt Herkunfts-Metadaten in Bildern, die mit ChatGPT auf der Website und über die DALL-E 3-API erstellt wurden, wobei die mobilen Pendants bis zum 12. Februar das gleiche Update erhalten.

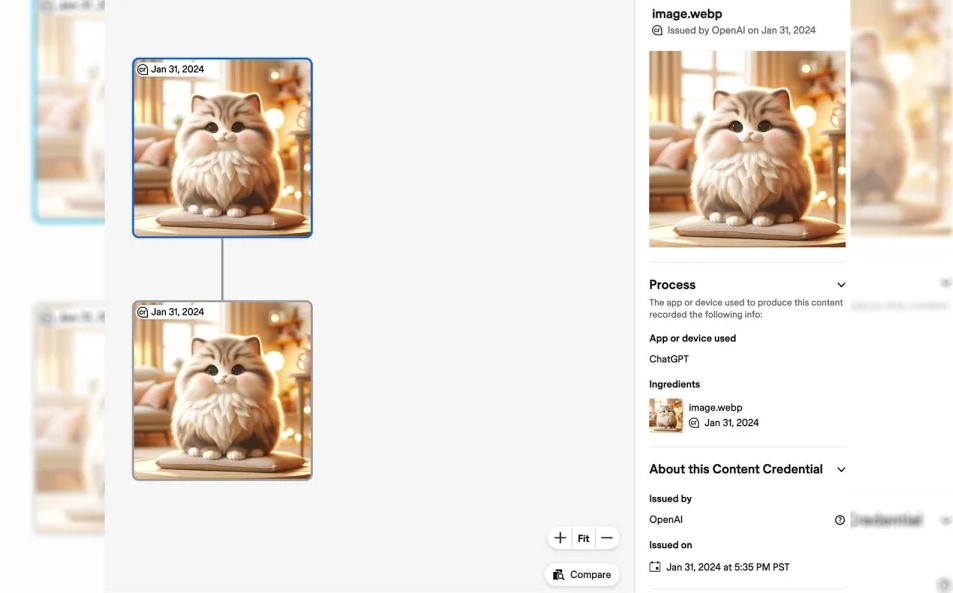

Die Metadaten entsprechen dem offenen Standard C2PA (Coalition for Content Provenance and Authenticity), und wenn ein solches Bild in das Tool Content Credentials Verify hochgeladen wird, kann seine Herkunftslinie zurückverfolgt werden. Ein mit ChatGPT erstelltes Bild zeigt beispielsweise ein erstes Metadatenmanifest, das seine Herkunft aus der DALL-E 3-API angibt, gefolgt von einem zweiten Metadatenmanifest, das zeigt, dass es aus ChatGPT stammt.

Trotz der ausgefeilten C2PA-Kryptotechnologie funktioniert diese Verifizierungsmethode nur, wenn die Metadaten intakt sind. Das Tool ist nutzlos, wenn Sie ein von der KI generiertes Bild ohne Metadaten hochladen – wie es bei jedem Screenshot oder Bild der Fall ist, das in soziale Medien hochgeladen wird. Es ist nicht verwunderlich, dass auch die aktuellen Beispielbilder auf der offiziellen DALL-E 3 Seite keine Ergebnisse brachten. Auf seiner FAQ-Seite räumt OpenAI ein, dass es kein Allheilmittel im Kampf gegen Desinformation ist, glaubt aber, dass der Schlüssel darin liegt, die Nutzer zu ermutigen, aktiv nach solchen Signalen zu suchen.

Während sich die jüngsten Bemühungen von OpenAI zur Bekämpfung gefälschter Inhalte derzeit auf statische Bilder beschränken, verfügt DeepMind von Google bereits über SynthID für digitale Wasserzeichen auf KI-generierten Bildern und Audiodaten. In der Zwischenzeit testet Meta unsichtbare Wasserzeichen mit seinem KI-Bildgenerator, der möglicherweise weniger störanfällig ist.